¿Qué es robots.txt?

Robots.txt es un archivo de texto con instrucciones para los robots de los motores de búsqueda que les indica qué páginas pueden y no pueden rastrear.

Estas instrucciones se especifican “permitiendo” o “desautorizando” el comportamiento de ciertos (o todos) los bots.

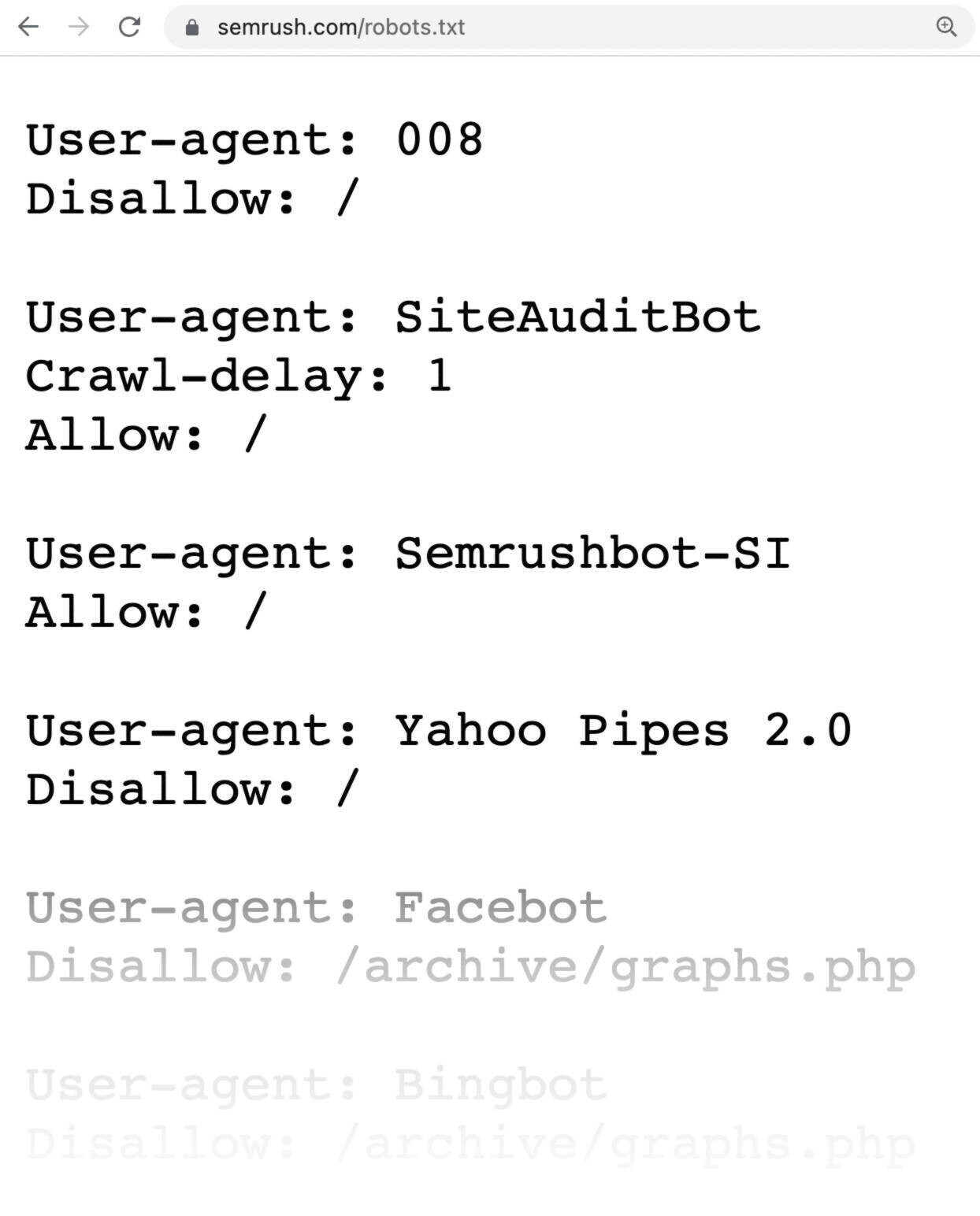

Este es el aspecto de un archivo robots.txt:

Para leer la nota completa visita el siguiente enlace https://es.semrush.com/blog/guia-completa-robots-txt/

0 Comentarios